2025-01-04 01:02:53

他們與來自大云(Azure,GoogleCloud,AWS)的一些人交談,試圖獲得許多H100。他們發現他們無法從大云中獲得大量分配,并且一些大云沒有良好的網絡設置。因此,他們與其他提供商(如CoreWeave,Oracle,Lambda,FluidStack)進行了交談。如果他們想自己購買GPU并擁有它們,也許他們也會與OEM和Nvidia交談。終,他們獲得了大量的GPU。現在,他們試圖獲得產品市場契合度。如果不是很明顯,這條途徑就沒有那么好了-請記住,OpenAI在更小的模型上獲得了產品市場契合度,然后將它們擴大了規模。但是,現在要獲得產品市場契合度,您必須比OpenAI的模型更適合用戶的用例,因此首先,您將需要比OpenAI開始時更多的GPU。預計至少到100年底,H2023將短缺數百或數千次部署。到2023年底,情況將更加清晰,但就目前而言,短缺似乎也可能持續到2024年的某些時間。GPU供需之旅。大版本取得聯系#作者:克萊·帕斯卡。問題和筆記可以通過電子郵件發送。新帖子:通過電子郵件接收有關新帖子的通知。幫助:看這里。自然的下一個問題-英偉達替代品呢?#自然的下一個問題是“好吧,競爭和替代方案呢?我正在探索硬件替代方案以及軟件方法。提交我應該探索的東西作為此表格的替代方案。例如。H100 GPU 支持 Tensor Core 技術。CPUH100GPU how much

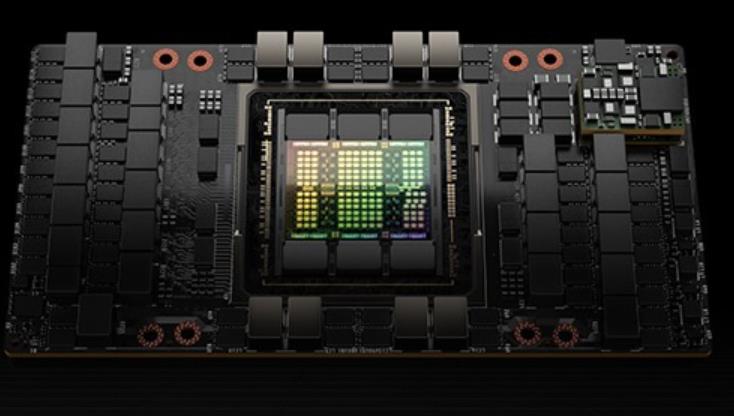

我理解的就是這些等待的線程在等待的時候無法執行其他工作)也是一個**的屏障,但不對到達的線程計數,同時也對事務進行計數。為寫入共享內存引入一個新的命令,同時傳遞要寫入的數據和事務計數。事務計數本質上是對字節計數異步事務屏障會在W**t命令處阻塞線程,直到所有生產者線程都執行了一個Arrive,所有事務計數之和達到期望值。異步事務屏障是異步內存拷貝或數據交換的一種強有力的新原語。集群可以進行線程塊到線程塊通信,進行隱含同步的數據交換,集群能力建立在異步事務屏障之上。H100HBM和L2cache內存架構HBM存儲器由內存堆棧組成,位于與GPU相同的物理封裝上,與傳統的GDDR5/6內存相比,提供了可觀的功耗和面積節省,允許更多的GPU被安裝在系統中。devicememory:駐留在HBM內存空間的CUDA程序訪問的全局和局部內存區域constantcache:駐留在devicememory內的不變內存空間texturecache:駐留在devicememory內的紋理和表面內存空間L2cache:對HBM內存進行讀和寫servicesmemory請求來源于GPU內的各種子系統HBM和L2內存空間對所有SM和所有運行在GPU上的應用程序都是可訪問的。HBM3或HBM2eDRAM和L2緩存子系統都支持數據壓縮和解壓縮技術。AmericaH100GPU購買H100 GPU 適用于人工智能訓練任務。

H100 GPU 支持新的 PCIe 4.0 接口,提供了更高的數據傳輸速度和帶寬,與前代 PCIe 3.0 相比,帶寬提升了兩倍。這使得 H100 GPU 在與主機系統通信時能夠更快速地交換數據,減少了 I/O 瓶頸,進一步提升了整體系統性能。PCIe 4.0 的支持使得 H100 GPU 能夠與現代主流服務器和工作站更好地兼容,充分發揮其高性能計算能力。H100 GPU 也采用了多項創新技術。其采用了先進的風冷和液冷混合散熱設計,能夠在高負載運行時保持穩定的溫度,確保 GPU 的長期穩定運行

他們與英偉達合作托管了一個基于NVIDIA的集群。Nvidia也是Azure的客戶。哪個大云擁有好的網絡?#Azure,CoreWeave和Lambda都使用InfiniBand。Oracle具有良好的網絡,它是3200Gbps,但它是以太網而不是InfiniBand,對于高參數計數LLM訓練等用例,InfiniBand可能比IB慢15-20%左右。AWS和GCP的網絡就沒有那么好了。企業使用哪些大云?#在一個大約15家企業的私有數據點中,所有15家都是AWS,GCP或Azure,零甲骨文。大多數企業將堅持使用現有的云。絕望的初創公司會去哪里,哪里就有供應。DGXCloud怎么樣,英偉達正在與誰合作?#“NVIDIA正在與的云服務提供商合作托管DGX云基礎設施,從Oracle云基礎設施(OCI)開始”-您處理Nvidia的銷售,但您通過現有的云提供商租用它(首先使用Oracle啟動,然后是Azure,然后是GoogleCloud,而不是使用AWS啟動)3233Jensen在上一次財報電話會議上表示:“理想的組合是10%的NvidiaDGX云和90%的CSP云。大云什么時候推出他們的H100預覽?#CoreWeave是個。34英偉達給了他們較早的分配,大概是為了幫助加強大型云之間的競爭(因為英偉達是投資者)。Azure于13月100日宣布H<>可供預覽。35甲骨文于21月100日宣布H<>數量有限。H100 GPU 優惠促銷,數量有限。

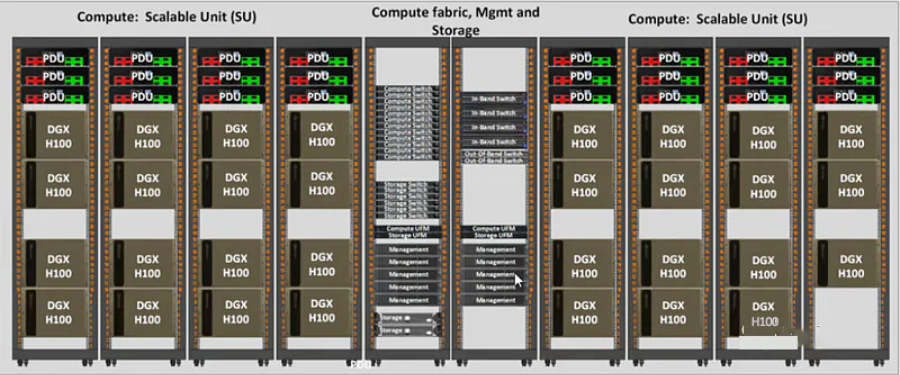

利用 NVIDIA H100 Tensor GPU,提供所有工作負載前所未有的效能、可擴展性和**性。 使用 NVIDIA® NVLink® Switch 系統,比較高可連接 256 個 H100 來加速百萬兆級工作負載,此外還有的 Transformer Engine,可解決一兆參數語言模型。 H100 所結合的技術創新,可加速大型語言模型速度,比前一代快上 30 倍,提供業界的對話式人工智能。英偉達 DGX SuperPOD架構采用英偉達的NVLink和NVSwitch系統,多可連接32個DGX節點,共256個H100 GPU。這是一個真正的人工智能基礎設施平臺;英偉達的DGX SuperPOD數據中心設計[4]讓我們對真正的企業人工智能基礎設施的巨大功率和冷卻需求有了一些了解。H100 GPU 擁有 8192 個 CUDA。H100GPU促銷

H100 GPU 支持 CUDA、OpenCL 和 Vulkan 編程模型。CPUH100GPU how much

H100 GPU 采用了 NVIDIA 的架構技術,其架構采用 Ampere 架構,使其在性能和能效方面都達到了一個新的高度。H100 GPU 具有 8192 個 CUDA ,能夠提供極高的并行處理能力,對于需要大量計算資源的任務,如深度學習訓練和科學計算,H100 GPU 能夠提升效率。其基礎時鐘頻率為 1410 MHz,增強時鐘頻率可達 1665 MHz,確保在高負載下依然能夠提供穩定的性能輸出,其 Tensor Core 性能可達 312 TFLOPS,特別適合深度學習和神經網絡訓練等需要大量矩陣運算的任務,極大地提升了計算效率。CPUH100GPU how much